Acompanhar uma indústria tão veloz quanto IA é uma tarefa difícil. Então, até que uma IA possa fazer isso por você, aqui está um resumo útil de histórias recentes no mundo do aprendizado de máquina, junto com pesquisas e experimentos notáveis que não abordamos por conta própria.

Esta semana, Meta lançou o o mais recente em sua série Llama de modelos generativos de IA: Lhama 3 8B e Lhama 3 70B. Capazes de analisar e escrever texto, os modelos são de “código aberto”, disse Meta – destinados a ser uma “peça fundamental” de sistemas que os desenvolvedores projetam com seus objetivos exclusivos em mente.

“Acreditamos que esses são os melhores modelos de código aberto de sua classe, ponto final”, escreveu Meta em um postagem no blog. “Estamos adotando o espírito do código aberto de lançamento antecipado e frequente.”

Só há um problema: os modelos Llama 3 não são realmente “código aberto”, pelo menos não no definição mais estrita.

O código aberto implica que os desenvolvedores podem usar os modelos como quiserem, sem restrições. Mas no caso do Llama 3 – assim como no Llama 2 – a Meta impôs certas restrições de licenciamento. Por exemplo, os modelos Llama não podem ser usados para treinar outros modelos. E desenvolvedores de aplicativos com mais de 700 milhões de usuários mensais devem solicitar uma licença especial da Meta.

Os debates sobre a definição de código aberto não são novos. Mas à medida que as empresas no espaço da IA brincam de forma rápida e solta com o termo, estão a injectar combustível em argumentos filosóficos de longa data.

Em agosto passado, um estudar em coautoria com pesquisadores da Carnegie Mellon, do AI Now Institute e da Signal Foundation, descobriram que muitos modelos de IA rotulados como “código aberto” trazem grandes vantagens – não apenas o Llama. Os dados necessários para treinar os modelos são mantidos em segredo. O poder computacional necessário para executá-los está além do alcance de muitos desenvolvedores. E o trabalho para ajustá-los é proibitivamente caro.

Então, se esses modelos não são verdadeiramente de código aberto, o que são exatamente? Esta é uma boa pergunta; definir código aberto em relação à IA não é uma tarefa fácil.

Uma questão pertinente não resolvida é se os direitos autorais, o mecanismo fundamental de IP no qual se baseia o licenciamento de código aberto, podem ser aplicados aos vários componentes e peças de um projeto de IA, em particular à estrutura interna de um modelo (por exemplo, incorporações). Depois, há a incompatibilidade entre a percepção do código aberto e como a IA realmente funciona para superá-lo: o código aberto foi concebido em parte para garantir que os desenvolvedores pudessem estudar e modificar o código sem restrições. Com a IA, porém, quais ingredientes você precisa para estudar e modificar estão abertos à interpretação.

Atravessando toda a incerteza, o estudo da Carnegie Mellon faz deixar claro o dano inerente ao fato de gigantes da tecnologia como Meta cooptarem a frase “código aberto”.

Muitas vezes, projetos de IA de “código aberto”, como o Llama, acabam iniciando novos ciclos — marketing gratuito — e fornecendo benefícios técnicos e estratégicos aos mantenedores dos projetos. A comunidade de código aberto raramente vê esses mesmos benefícios e, quando os vê, são marginais em comparação com os mantenedores.

Em vez de democratizar a IA, os projetos de IA de “código aberto” – especialmente os das grandes empresas tecnológicas – tendem a consolidar e expandir o poder centralizado, dizem os coautores do estudo. É bom ter isso em mente na próxima vez que surgir um grande lançamento de modelo de “código aberto”.

Aqui estão algumas outras histórias dignas de nota sobre IA dos últimos dias:

- Meta atualiza seu chatbot: Coincidindo com a estreia do Llama 3, a Meta atualizou seu chatbot de IA no Facebook, Messenger, Instagram e WhatsApp – Meta AI – com um backend alimentado pelo Llama 3. Também lançou novos recursos, incluindo geração mais rápida de imagens e acesso a resultados de pesquisa na web.

- Pornografia gerada por IA: Ivan escreve sobre como o Oversight Board, o conselho político semi-independente da Meta, está voltando sua atenção para como as plataformas sociais da empresa estão lidando com imagens explícitas geradas por IA.

- Marcas d’água instantâneas: O serviço de mídia social Snap planeja adicionar marcas d’água às imagens geradas por IA em sua plataforma. Uma versão translúcida do logotipo Snap com um emoji brilhante, a nova marca d'água será adicionada a qualquer imagem gerada por IA exportada do aplicativo ou salva no rolo da câmera.

- O novo Atlas: A empresa de robótica de propriedade da Hyundai, Boston Dynamics, revelou seu robô humanóide Atlas de próxima geração, que, em contraste com seu antecessor movido a sistema hidráulico, é totalmente elétrico – e de aparência muito mais amigável.

- Humanóides em humanóides: Para não ficar atrás da Boston Dynamics, o fundador da Mobileye, Amnon Shashua, lançou uma nova startup, Menteebot, focada na construção de sistemas robóticos bibedais. Um vídeo de demonstração mostra o protótipo do Menteebot caminhando até uma mesa e pegando frutas.

- Reddit, traduzido: Em uma entrevista com Amanda, o CPO do Reddit, Pali Bhat, revelou que um recurso de tradução de idiomas baseado em IA para levar a rede social a um público mais global está em desenvolvimento, junto com uma ferramenta de moderação assistida treinada nas decisões e ações anteriores dos moderadores do Reddit.

- Conteúdo do LinkedIn gerado por IA: O LinkedIn começou discretamente a testar uma nova maneira de aumentar suas receitas: uma assinatura da LinkedIn Premium Company Page, que – por taxas que parecem tão altas quanto US$ 99/mês – inclui IA para escrever conteúdo e um conjunto de ferramentas para aumentar o número de seguidores.

- Um termômetro: A fábrica moonshot da Alphabet, controladora do Google, X, revelou esta semana o Projeto Bellwether, sua mais recente tentativa de aplicar tecnologia a alguns dos maiores problemas do mundo. Aqui, isso significa usar ferramentas de IA para identificar desastres naturais, como incêndios florestais e inundações, o mais rápido possível.

- Protegendo crianças com IA: Ofcom, o regulador encarregado de fazer cumprir a Lei de Segurança Online do Reino Unido, planeja lançar uma exploração sobre como a IA e outras ferramentas automatizadas podem ser usadas para detectar e remover proativamente conteúdo ilegal online, especificamente para proteger as crianças de conteúdos prejudiciais.

- OpenAI chega ao Japão: A OpenAI está se expandindo para o Japão, com a abertura de um novo escritório em Tóquio e planos para um modelo GPT-4 otimizado especificamente para o idioma japonês.

Mais aprendizados de máquina

Créditos da imagem: DrAfter123/Getty Images

Um chatbot pode fazer você mudar de ideia? Pesquisadores suíços descobriram que não só podem, mas se estiverem pré-armados com algumas informações pessoais sobre você, eles podem realmente ser mais persuasivo em um debate do que um humano com a mesma informação.

“Esta é a Cambridge Analytica com esteróides”, disse o líder do projeto, Robert West, da EPFL. Os investigadores suspeitam que o modelo – GPT-4 neste caso – baseou-se no seu vasto acervo de argumentos e factos online para apresentar um caso mais convincente e confiante. Mas o resultado fala por si. Não subestime o poder dos LLMs em questões de persuasão, alertou West: “No contexto das próximas eleições nos EUA, as pessoas estão preocupadas porque é onde este tipo de tecnologia é sempre testado pela primeira vez. Uma coisa que sabemos com certeza é que as pessoas usarão o poder de grandes modelos de linguagem para tentar influenciar as eleições.”

Por que esses modelos são tão bons em linguagem? Essa é uma área na qual há uma longa história de pesquisa, desde ELIZA. Se você está curioso sobre uma das pessoas que já esteve lá por muito tempo (e fez muito isso sozinho), dê uma olhada este perfil sobre Christopher Manning de Stanford. Ele acaba de receber a Medalha John von Neuman; parabéns!

Numa entrevista com título provocativo, outro pesquisador de IA de longa data (que agraciou o palco do TechCrunch também), Stuart Russell e o pós-doutorado Michael Cohen especulam sobre “Como evitar que a IA mate todos nós.” Provavelmente é uma boa coisa descobrir mais cedo ou mais tarde! Porém, não é uma discussão superficial – são pessoas inteligentes falando sobre como podemos realmente entender as motivações (se essa for a palavra certa) dos modelos de IA e como as regulamentações devem ser construídas em torno deles.

A entrevista é na verdade sobre um artigo na Science publicado no início deste mês, no qual propõem que IAs avançadas capazes de agir estrategicamente para atingir os seus objetivos, que chamam de “agentes de planejamento de longo prazo”, podem ser impossíveis de testar. Essencialmente, se um modelo aprender a “compreender” os testes que deve passar para ter sucesso, poderá muito bem aprender formas de negar ou contornar criativamente esses testes. Já vimos isso em pequena escala, por que não em grande escala?

Russell propõe restringir o hardware necessário para fabricar tais agentes… mas é claro que Los Alamos e Sandia National Labs acabaram de receber suas entregas. LANL acaba de realizar a cerimônia de inauguração de Venadoum novo supercomputador destinado à pesquisa de IA, composto por 2.560 chips Grace Hopper Nvidia.

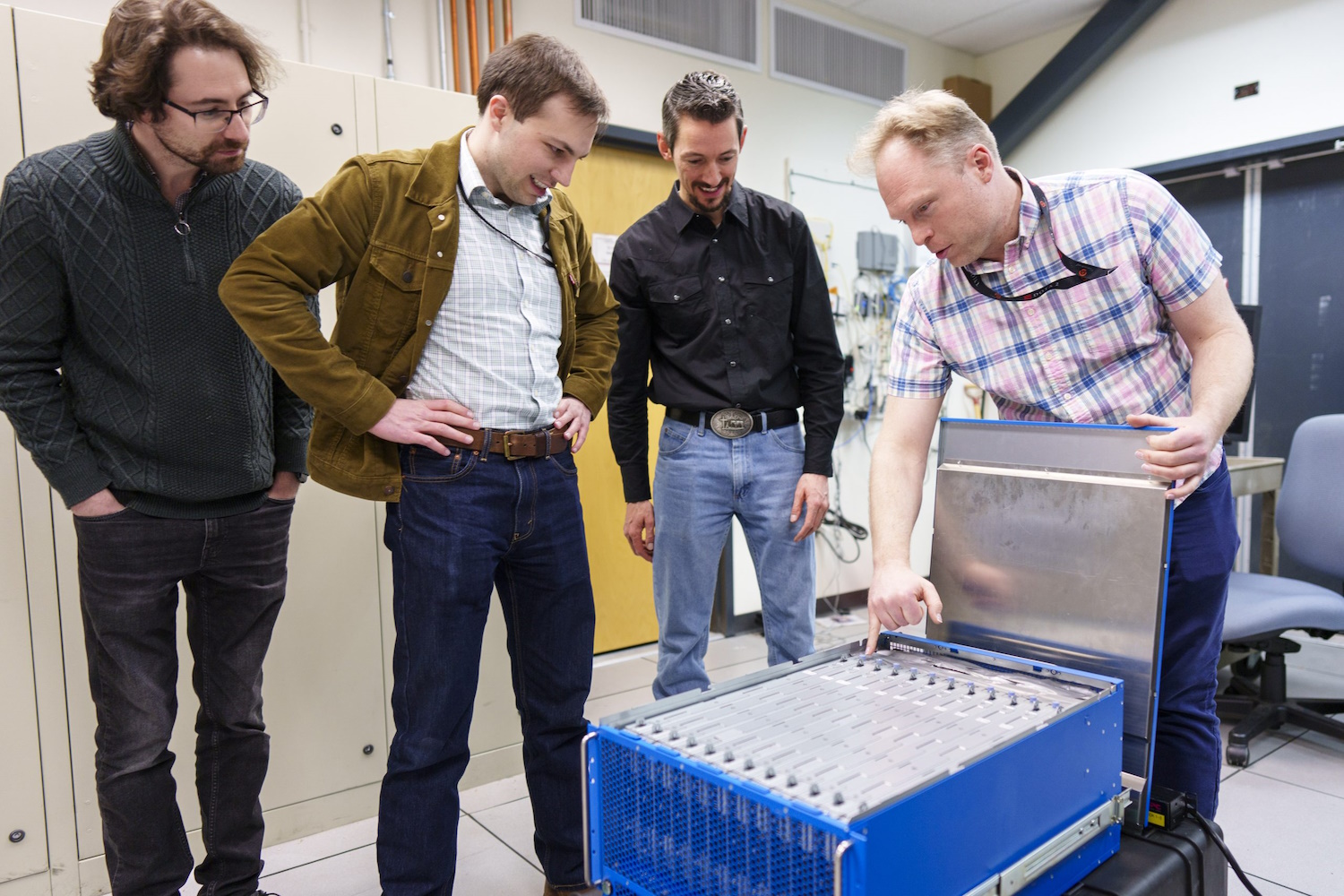

Pesquisadores investigam o novo computador neuromórfico.

E Sandia acaba de receber “um extraordinário sistema de computação baseado no cérebro chamado Hala Point”, com 1,15 bilhão de neurônios artificiais, construído pela Intel e considerado o maior sistema desse tipo no mundo. A computação neuromórfica, como é chamada, não se destina a substituir sistemas como o Venado, mas sim a buscar novos métodos de computação que sejam mais parecidos com o cérebro do que a abordagem bastante focada em estatísticas que vemos nos modelos modernos.

“Com este sistema de bilhões de neurônios, teremos a oportunidade de inovar em escala tanto novos algoritmos de IA que podem ser mais eficientes e mais inteligentes do que os algoritmos existentes, quanto novas abordagens semelhantes às do cérebro para algoritmos de computador existentes, como otimização e modelagem”, disse O pesquisador Sandia, Brad Aimone. Parece ótimo… simplesmente ótimo!