Acompanhar uma indústria tão veloz quanto IA é uma tarefa difícil. Então, até que uma IA possa fazer isso por você, aqui está um resumo útil de histórias recentes no mundo do aprendizado de máquina, junto com pesquisas e experimentos notáveis que não abordamos por conta própria.

Esta semana na IA, o ciclo de notícias finalmente (finalmente!) Acalmou-se um pouco antes da temporada de férias. Mas isso não quer dizer que houvesse escassez de assuntos para escrever, uma bênção e uma maldição para este repórter privado de sono.

Uma manchete específica da AP chamou minha atenção esta manhã: “Geradores de imagens de IA estão sendo treinados em fotos explícitas de crianças”. A essência da história é, LAION, um conjunto de dados usado para treinar muitos geradores populares de imagens de IA comerciais e de código aberto, incluindo Difusão Estável e Imagem, contém milhares de imagens de suspeitas de abuso sexual infantil. Um grupo de vigilância baseado em Stanford, o Stanford Internet Observatory, trabalhou com instituições de caridade antiabuso para identificar o material ilegal e denunciar as ligações às autoridades.

Agora, a LAION, uma organização sem fins lucrativos, retirou do ar os seus dados de treinamento e se comprometeu a remover os materiais ofensivos antes de republicá-los. Mas o incidente serve para sublinhar quão pouca atenção está a ser dada aos produtos generativos de IA à medida que as pressões competitivas aumentam.

Graças à proliferação de ferramentas de criação de modelos de IA sem código, está se tornando extremamente fácil treinar IA generativa em qualquer conjunto de dados imaginável. É uma bênção para startups e gigantes da tecnologia lançar esses modelos. Com a menor barreira à entrada, porém, surge a tentação de pôr de lado a ética em favor de um caminho acelerado para o mercado.

A ética é difícil – não há como negar isso. Examinar as milhares de imagens problemáticas do LAION, para tomar o exemplo desta semana, não acontecerá da noite para o dia. E, idealmente, o desenvolvimento da IA de forma ética envolve trabalhar com todas as partes interessadas relevantes, incluindo organizações que representam grupos frequentemente marginalizados e afetados negativamente pelos sistemas de IA.

A indústria está repleta de exemplos de decisões de lançamento de IA tomadas tendo em mente os acionistas, e não os especialistas em ética. Tomemos por exemplo o Bing Chat (agora Microsoft Copilot), o chatbot da Microsoft com tecnologia de IA no Bing, que pelo menos lançar comparou um jornalista a Hitler e insultou a sua aparência. Em outubro, o ChatGPT e o Bard, concorrente do ChatGPT do Google, ainda estavam dando conselhos médicos desatualizados e racistas. E a versão mais recente do gerador de imagens DALL-E da OpenAI mostra evidência do anglocentrismo.

Basta dizer que estão a ser causados danos na procura da superioridade da IA – ou pelo menos da noção de superioridade da IA de Wall Street. Talvez com a aprovação dos regulamentos de IA da UE, que ameaçam multas pelo não cumprimento de certas barreiras de proteção da IA, haja alguma esperança no horizonte. Mas o caminho a percorrer é realmente longo.

Aqui estão algumas outras histórias dignas de nota sobre IA dos últimos dias:

Previsões para IA em 2024: Devin expõe suas previsões para a IA em 2024, abordando como a IA pode impactar as eleições primárias dos EUA e o que vem por aí para a OpenAI, entre outros tópicos.

Contra a pseudontropia: Devin também escreveu sugerindo que a IA fosse proibida de imitar o comportamento humano.

Microsoft Copilot obtém criação musical: Copilot, o chatbot com tecnologia de IA da Microsoft, agora pode compor músicas graças a uma integração com o aplicativo de música GenAI Suno.

Reconhecimento facial lançado na Rite Aid: A Rite Aid foi proibida de usar tecnologia de reconhecimento facial por cinco anos depois que a Comissão Federal de Comércio descobriu que o “uso imprudente de sistemas de vigilância facial” pela gigante das drogarias dos EUA deixou os clientes humilhados e colocou suas “informações confidenciais em risco”.

A UE oferece recursos de computação: A UE está a expandir o seu plano, originalmente anunciado em Setembro e iniciado no mês passado, para apoiar startups locais de IA, proporcionando-lhes acesso ao poder de processamento para formação de modelos nos supercomputadores do bloco.

OpenAI dá ao conselho novos poderes: A OpenAI está expandindo seus processos internos de segurança para afastar a ameaça da IA prejudicial. Um novo “grupo consultivo de segurança” ficará acima das equipes técnicas e fará recomendações à liderança, e o conselho recebeu poder de veto.

Perguntas e respostas com Ken Goldberg da UC Berkeley: Para seu boletim informativo regular do Actuator, Brian conversou com Ken Goldberg, professor da UC Berkeley, fundador de uma startup e um roboticista talentoso, para falar sobre robôs humanóides e tendências mais amplas na indústria robótica.

Os CIOs vão devagar com a geração AI: Ron escreve que, embora os CIOs estejam sob pressão para oferecer o tipo de experiência que as pessoas veem quando jogam com o ChatGPT online, a maioria está adotando uma abordagem deliberada e cautelosa para adotar a tecnologia para a empresa.

Editores de notícias processam o Google por causa de IA: Uma ação coletiva movida por vários editores de notícias acusa o Google de “sifão[ing] off” do conteúdo de notícias por meios anticompetitivos, em parte por meio de tecnologia de IA, como o Search Generative Experience (SGE) do Google e o chatbot Bard.

As tintas OpenAI tratam de Axel Springer: Falando em editores, a OpenAI fechou um acordo com Axel Springer, proprietário de publicações com sede em Berlim, incluindo Business Insider e Politico, para treinar seus modelos generativos de IA no conteúdo do editor e adicionar artigos recentes publicados por Axel Springer ao ChatGPT.

Google traz Gêmeos para mais lugares: O Google integrou seus modelos Gemini com mais de seus produtos e serviços, incluindo sua plataforma de desenvolvimento de IA gerenciada por Vertex AI e AI Studio, a ferramenta da empresa para criação de chatbots baseados em IA e outras experiências nesse sentido.

Mais aprendizados de máquina

Certamente a pesquisa mais selvagem (e mais fácil de interpretar mal) das últimas duas semanas deve ser vida2vec, um estudo dinamarquês que utiliza inúmeros dados da vida de uma pessoa para prever como ela é e quando morrerá. Aproximadamente!

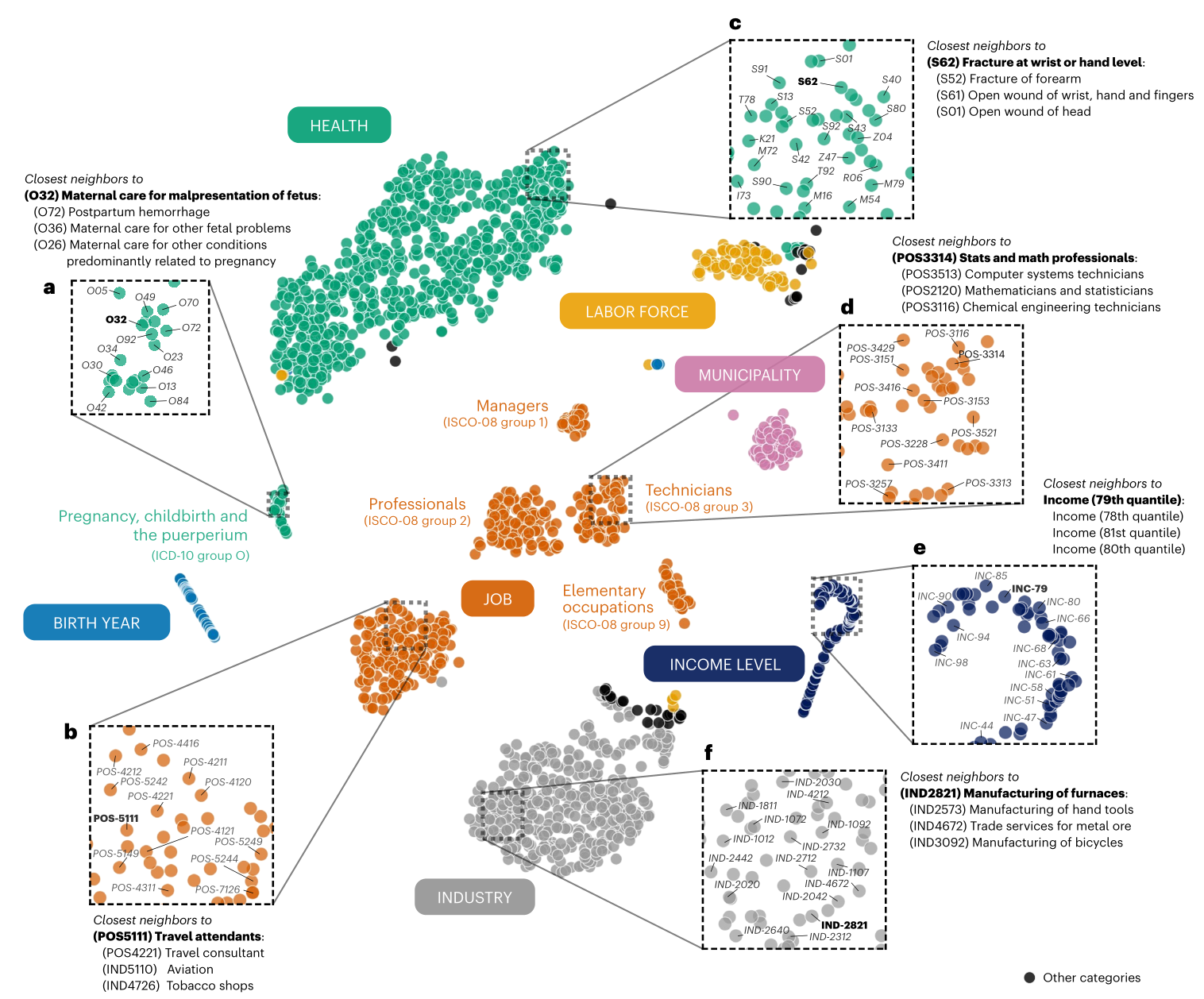

Visualização do mapeamento do life2vec de vários conceitos e eventos relevantes da vida.

O estudo não reivindica precisão oracular (digamos que três vezes mais rápido, aliás), mas pretende mostrar que, se nossas vidas são a soma de nossas experiências, esses caminhos podem ser extrapolados de alguma forma usando as atuais técnicas de aprendizado de máquina. Entre educação, educação, trabalho, saúde, passatempos e outras métricas, pode-se prever razoavelmente não apenas se alguém é, digamos, introvertido ou extrovertido, mas como estes factores podem afectar a esperança de vida. Ainda não estamos nos níveis “pré-crime” aqui, mas você pode apostar que as companhias de seguros mal podem esperar para licenciar este trabalho.

Outra grande afirmação foi feita pelos cientistas da CMU que criaram um sistema chamado Coscientist, um assistente baseado em LLM para pesquisadores que pode realizar muitas tarefas laboratoriais de forma autônoma. Atualmente, está limitado a certos domínios da química, mas, assim como os cientistas, modelos como esses serão especialistas.

O pesquisador principal Gabe Gomes disse à Nature: “O momento em que vi uma inteligência não orgânica ser capaz de planejar, projetar e executar de forma autônoma uma reação química inventada por humanos, foi incrível. Foi um momento de ‘puta merda’.” Basicamente, utiliza um LLM como o GPT-4, ajustado em documentos químicos, para identificar reações, reagentes e procedimentos comuns e executá-los. Portanto, você não precisa dizer a um técnico de laboratório para sintetizar 4 lotes de algum catalisador – a IA pode fazer isso e você nem precisa segurar sua mão.

Os pesquisadores de IA do Google também tiveram uma grande semana, mergulhando em alguns domínios fronteiriços interessantes. FunSearch pode soar como Google para crianças, mas na verdade é uma abreviação de pesquisa de função, que, como Coscientist, é capaz de fazer e ajudar a fazer descobertas matemáticas. Curiosamente, para evitar alucinações, este (como outros recentemente) usa um par correspondente de modelos de IA muito parecidos com a “antiga” arquitetura GAN. Um teoriza, o outro avalia.

Embora o FunSearch não faça nenhuma descoberta inovadora, ele pode pegar o que está disponível e aprimorá-lo ou reaplicá-lo em novos lugares, portanto, uma função que um domínio usa, mas outro desconhece, pode ser usada para melhorar um padrão da indústria algoritmo.

EstiloDrop é uma ferramenta útil para pessoas que desejam replicar certos estilos por meio de imagens generativas. O problema (na opinião do pesquisador) é que se você tiver um estilo em mente (digamos “pastéis”) e descrevê-lo, o modelo terá muitos subestilos de “pastéis” para extrair, então os resultados serão imprevisível. StyleDrop permite fornecer um exemplo do estilo que você está pensando, e o modelo baseará seu trabalho nisso – é basicamente um ajuste fino supereficiente.

Créditos da imagem: Google

A postagem do blog e o artigo mostram que ele é bastante robusto, aplicando um estilo de qualquer imagem, seja uma foto, pintura, paisagem urbana ou retrato de gato, a qualquer outro tipo de imagem, até mesmo o alfabeto (notoriamente difícil por algum motivo).

O Google também está avançando no videogame generativo com o VideoPoet, que usa uma base LLM (como tudo hoje em dia… o que mais você vai usar?) para realizar um monte de tarefas de vídeo, transformando texto ou imagens em vídeo, estendendo ou estilizar vídeos existentes e assim por diante. O desafio aqui, como todo projeto deixa claro, não é simplesmente criar uma série de imagens que se relacionem entre si, mas torná-las coerentes por períodos mais longos (como mais de um segundo) e com grandes movimentos e mudanças.

Créditos da imagem: Google

VideoPoeta parece que move a bola para frente, mas como você pode ver, os resultados ainda são bem estranhos. Mas é assim que essas coisas progridem: primeiro são inadequadas, depois são estranhas e depois misteriosas. Presumivelmente, eles saem estranhos em algum momento, mas ninguém realmente chegou lá ainda.

Do lado prático, pesquisadores suíços têm aplicado modelos de IA à medição de neve. Normalmente confiaríamos em estações meteorológicas, mas estas podem estar distantes e temos todos esses lindos dados de satélite, certo? Certo. Assim, a equipa da ETHZ obteve imagens públicas de satélite da constelação Sentinel-2, mas, como afirma o líder Konrad Schindler, “apenas olhar para os pedaços brancos nas imagens de satélite não nos diz imediatamente quão profunda é a neve”.

Então, eles inseriram dados de terreno para todo o país do Departamento Federal de Topografia (como o nosso USGS) e treinaram o sistema para fazer estimativas não apenas com base em bits brancos em imagens, mas também em dados reais e tendências, como padrões de derretimento. A tecnologia resultante está sendo comercializada pela ExoLabs, com quem estou prestes a entrar em contato para saber mais.

Uma palavra de cautela de Stanford, porém – por mais poderosas que sejam aplicações como as acima, observe que nenhuma delas envolve muito preconceito humano. Quando se trata de saúde, isso de repente se torna um grande problema, e é na saúde que muitas ferramentas de IA estão sendo testadas. Pesquisadores de Stanford mostraram que os modelos de IA propagam “antigos tropos raciais médicos”. O GPT-4 não sabe se algo é verdadeiro ou não, por isso pode repetir, e faz, afirmações antigas e refutadas sobre grupos, como a de que os negros têm menor capacidade pulmonar. Não! Fique atento se estiver trabalhando com qualquer tipo de modelo de IA na saúde e na medicina.

Por fim, aqui está um conto escrito por Bard com roteiro de filmagem e instruções, renderizado por VideoPoet. Cuidado, Pixar!